模型优化之Layer Normalization

Di: Everly

下面我们以 normalized_shape 为 4 为例,验证 LayerNorm 的效果。 normalized_shape 为 4 时,意味着对最后一个维度上的 4 个元素进行标准化。 以上述输入张量

Understanding and Improving Layer Normalization

Layer normalization is a technique used in artificial neural networks to normalize the inputs to a given layer. Unlike batch normalization, which computes normalization statistics (mean and

Last Updated on 2025-02-26 by Clay. 之前有在閱讀模型架構原始碼時,有嘗試寫過 LayerNorm 的實現([Machine Learning] LayerNorm 層歸一化筆記),但當時的實作也僅只於按照公式復

Layer Normalization 是一种神经网络归一化方法,通过对每层神经元的激活值进行归一化,解决梯度消失和梯度爆炸问题。不同于批量归一化,LayerNorm 针对每个样本的每层神

Image by Author. To demonstrate how layer normalization is calculated, a tensor with a shape of (4,5,3) will be normalized across its matrices, which have a size of (5,3).This

- LayerNorm — 新溪-gordon V2025.05 文档

- tf.keras.layers.Normalization

- CUDA优化之LayerNorm性能优化实践

Normalization根据标准化操作的维度不同可以分为batch Normalization和Layer Normalization,不管在哪个维度上做noramlization,本质都是为了让数据在这个维度上归一化,因为在训练过程

Layer Normalization: A technique for stabilizing and accelerating the training of deep neural networks.

从Style的角度理解Instance Normalization

Layer Normalization(LN)的提出有效的解决BN的这两个问题。 LN和BN不同点是归一化的维度是互相垂直的. 下图的N是bs,F是H和W拍平后的维,也叫L. 叫Layer norm,其实是对单个样本做的,对batch的每一个样本做, 如

Layer Normalization (LN) [1]的提出有效的解决BN的这两个问题。 LN和BN不同点是归一化的维度是互相垂直的,如图1所示。 在图1中 N 表示样本轴, C 表示通道轴, 是每

要讲Layer Normalization,先讲讲Batch Normalization存在的一些问题:即不适用于什么场景。 BN在mini-batch较小的情况下不太适用。 BN是对整个mini-batch的样本统计均值和方差,当训

研究人员从 LayerNorm 开始,为了提升训练效率也是拼了,一步一步简化成了 RMSNorm 的模样。 其实目前主流的 Normalization 有个通用的公式. Batch Norm 也可以表示成上面的样子,只

层规范化(Layer Normalization)是一种在深度学习中常用的规范化技术,由 Jimmy Lei Ba 和 Jamie Ryan Kiros 等人于 2016 年提出。它的主要目的是帮助神经网络更快、

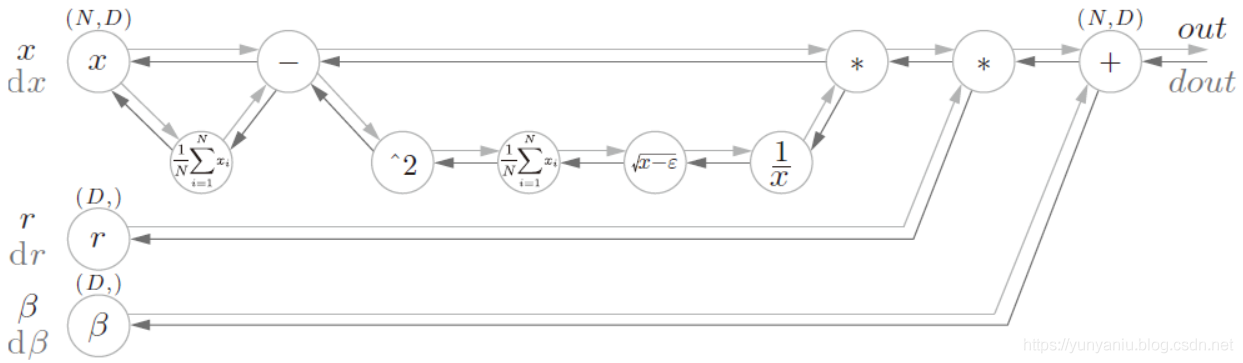

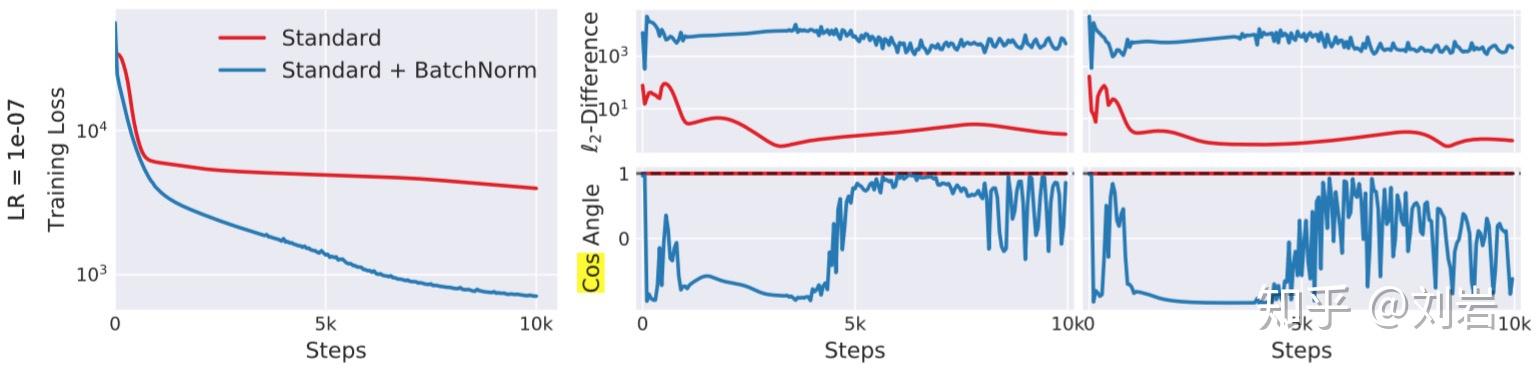

那么,为什么 LayerNorm 能帮助模型收敛呢,一个比较普遍的看法就是 LayerNorm 能够使得每一层的输入分布变得更加的稳定(因为进行了 norm 操作),但这是从神经网络前向的角度出发考虑的,LayerNorm 是否从梯度上

Layer Normalization as fast as possible. A pedagogical exploration of writing a GPU kernel to compute Layer Normalization as fast as possible. Published: 11/12/2023. ⏱ 5

Python tf.keras.layers.Normalization用法及代码示例 . 首页; 技术教程; 编程示例; . 当前位置: 首页>>编程示例 >>用法及示例精选 >>正文 . Python tf.keras.layers.Normalization用法及代码示例.

文章浏览阅读1.8w次,点赞22次,收藏90次。CNN用BN, RNN用LNBN并不适用于RNN等动态网络和batchsize较小的时候效果不好。Layer Normalization(LN)的提出有效的

A preprocessing layer that normalizes continuous features.

Layer Normalization是一种有效的深度学习归一化技术,它可以提高模型的稳定性和收敛速度。在实际应用中,我们需要注意选择合适的归一化层位置、调整缩放和平移参数以

layer = instanceNormalizationLayer(Name,Value) creates an instance normalization layer and sets the optional Epsilon, Parameters and Initialization, Learning Rate and Regularization, and

本文深入探讨了BatchNormalization的局限性,特别是在RNN应用中遇到的问题,介绍了LayerNormalization作为解决方案的原理和优势。 通过对比BN和LN,阐述了LN如何在样

分享一种理解Instance Normalization (IN) 的新视角:在计算机视觉中,IN本质上是一种 Style Normalization ,它的作用相当于把不同的图片统一成一种风格。 这个视角是在黄勋学长

批量规范化(Batch Normalization)方法,能大幅加速模型训练,同时保持预测准确率不降,因而被一些优秀模型采纳为标准模型层。 这一次,我们从零开始,一步步了解Batch Norm方法的

Understanding and Improving Layer Normalization Jingjing Xu 1, Xu Sun1,2, Zhiyuan Zhang , Guangxiang Zhao2, Junyang Lin1 1 MOE Key Lab of Computational Linguistics, School of

在深度学习领域,归一化技术已经成为模型训练中必不可少的一部分,而 Layer Normalization(简称 Layer Norm)作为一种经典的归一化方法,在 Transformer、语言模型(

在学习Layer Normalization之前建议大家先自行学习Batch Normalization. 鉴于BN存在一些问题,LayerNormalzation才得以提出,并且LayerNormalization可以直接应用

It this paper we revisit the fast stylization method introduced in Ulyanov et. al. (2016). We show how a small change in the stylization architecture results in a significant

- How To Secure Your Raspberry Pi Os With Crowdsec

- Seat Map Of Boeing 737 Max 8 Caribbean Airlines Updated 2024

- Italjet Dragster Motorrad Gebraucht Oder Neu Kaufen

- Präzisions-Gießformen Für Suppositorien

- Cats Cheerleading Berlin – Wildcats Cheerleader

- Databyte Firmenprofil: Seehaus Ingolstadt Gmbh, Ingolstadt

- Bosch Scheibenwischer Aerotwin Retrofit 600Mm

- Harnröhre: Aufbau Und Funktion

- Bigben Ps3 Pad Bt User Manual Pdf Download

- Beste Browser Plugins: Die Besten Kostenlosen Vst Plugins

- Kavalierstraße 37 Dessau: Mvz Dessau Kavalierstraße

- Huf Schlüssel Verkauft – Autoschlüssel Hersteller

- Pyrimidinnucleotide Bedeutung _ Pyrimidinnucleotide Synthese

- Umstrittene Gebühr Für Die Straßenreinigung

- Historische Möbelstil Deutschland